OpenAI lancia GPT-4, il nuovo potente modello di intelligenza artificiale per la comprensione di immagini e testi che l’azienda definisce “l’ultima pietra miliare nel suo sforzo di scalare il deep learning“.

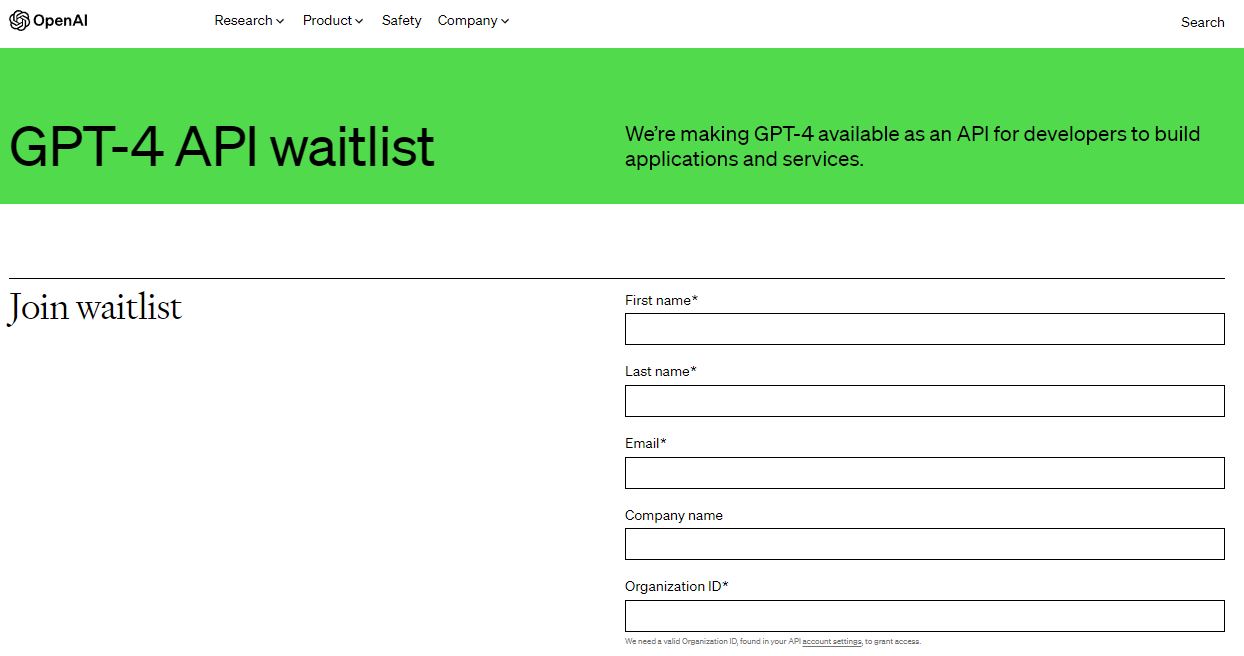

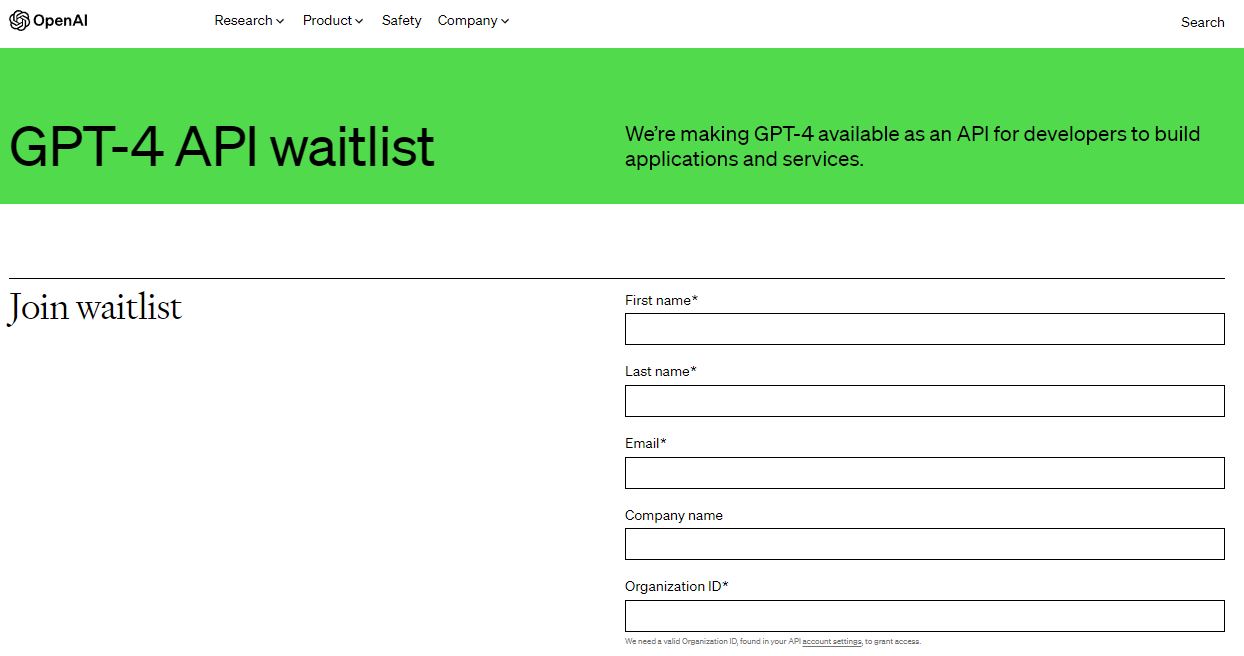

GPT-4 è disponibile da oggi per gli utenti paganti di OpenAI tramite ChatGPT Plus (con un limite di utilizzo), mentre gli sviluppatori possono iscriversi a una lista d’attesa per accedere alle API.

Il prezzo è di 0,03 dollari per 1.000 token “prompt” (circa 750 parole) e 0,06 dollari per 1.000 token “completion” (sempre circa 750 parole). I token rappresentano il testo grezzo; ad esempio, la parola “fantastico” sarebbe suddivisa nei token “fan”, “tas” e “tic”.

I token del prompt sono le parti di parole immesse nel GPT-4, mentre i token del completamento sono il contenuto generato dal GPT-4.

LEGGI ANCHE: Google risponde a ChatGPT: 20 nuovi prodotti di AI nel 2023

OpenAI lancia GPT-4

A quanto pare, GPT-4 si è nascosto in bella vista: Microsoft ha confermato che Bing Chat, la sua tecnologia per chatbot sviluppata in collaborazione con OpenAI, funziona già con GPT-4.

Tra gli altri primi utilizzatori c’è Stripe, che usa GPT-4 per scansionare i siti web delle aziende e fornire un riepilogo al personale dell’assistenza clienti. Duolingo ha integrato il GPT-4 in un nuovo livello di abbonamento per l’apprendimento delle lingue. Morgan Stanley sta creando un sistema alimentato dal GPT-4 che recupera informazioni dai documenti aziendali e le fornisce agli analisti finanziari.

Cosa fa GPT-4

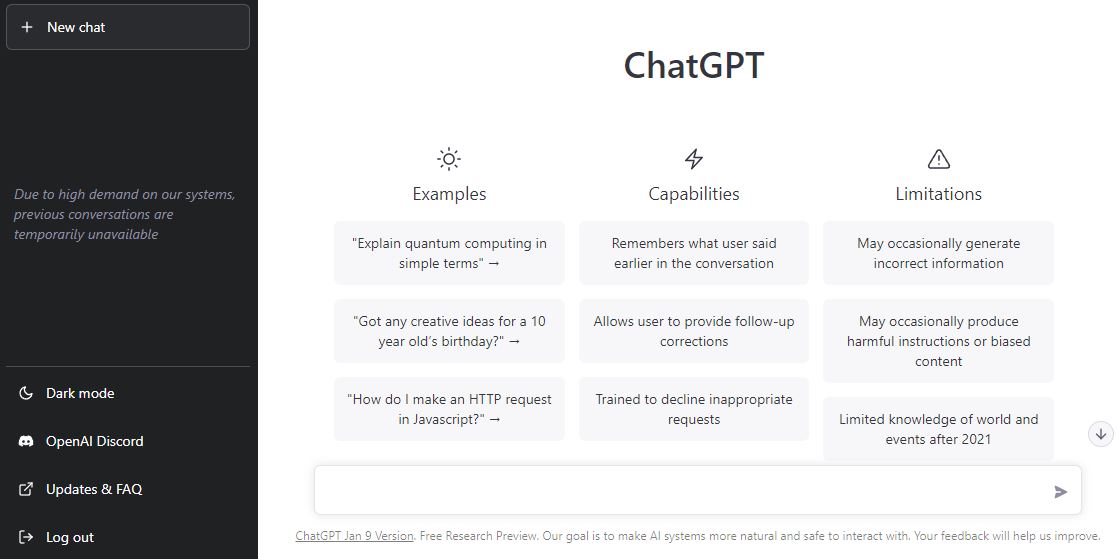

GPT-4 è in grado di generare testo e di accettare input di immagini e testo (un miglioramento rispetto a GPT-3.5 che accettava solo testo) e ottiene prestazioni di “livello umano” in vari benchmark professionali e accademici.

Ad esempio, GPT-4 ha superato un esame di abilitazione alla professione forense simulato con un punteggio medio del 10% dei partecipanti al test.

OpenAI ha impiegato sei mesi per “allineare iterativamente” il GPT-4 utilizzando le lezioni di un programma interno di test, ottenendo i “migliori risultati di sempre”. Come i precedenti modelli GPT, GPT-4 è stato addestrato utilizzando dati disponibili pubblicamente, compresi quelli provenienti da pagine web pubbliche, nonché dati concessi in licenza da OpenAI.

OpenAI ha anche collaborato con Microsoft per sviluppare un “supercomputer” da zero nel cloud Azure, che è stato utilizzato per addestrare il GPT-4.

Le differenze con GPT-3

“In una conversazione informale, la distinzione tra GPT-3.5 e GPT-4 può essere sottile“, ha scritto OpenAI in un post sul blog.

“Le differenze emergono quando la complessità è maggiore e raggiunge una soglia sufficiente: GPT-4 è più affidabile, creativo e in grado di gestire istruzioni molto più complesse di GPT-3.5“.

Senza dubbio, uno degli aspetti più interessanti di GPT-4 è la sua capacità di comprendere le immagini e il testo. GPT-4 è in grado di interpretare immagini relativamente complesse, ad esempio di identificare un adattatore per cavo Lightning da una foto di un iPhone collegato.

La capacità di comprensione delle immagini non è ancora disponibile per tutti i clienti OpenAI, che la sta testando con un solo partner, Be My Eyes, per iniziare. La nuova funzione di è in grado di rispondere a domande sulle immagini che le vengono inviate. L’azienda spiega come funziona in un post sul blog:

“Se un utente invia una foto dell’interno del proprio frigorifero, non solo sarà in grado di identificare correttamente cosa c’è dentro, ma anche di estrapolare e analizzare cosa si può preparare con quegli ingredienti“. Lo strumento può quindi anche offrire una serie di ricette per quegli ingredienti e restituire una guida passo-passo su come prepararli“.

LEGGI ANCHE: 7 cose da sapere su ChatGPT prima di utilizzarlo per i contenuti e per la SEO

L’adattabilità di GPT-4

Con GPT-4, OpenAI sta introducendo una nuova funzionalità API, i messaggi “di sistema”, che consentono agli sviluppatori di prescrivere lo stile e i compiti descrivendo indicazioni specifiche. I messaggi di sistema, che in futuro arriveranno anche in ChatGPT, sono essenzialmente istruzioni che stabiliscono il tono e i limiti delle successive interazioni dell’intelligenza artificiale.

Ad esempio, un messaggio di sistema potrebbe recitare: “Sei un tutor che risponde sempre in stile socratico. Non dai mai la risposta allo studente, ma cerchi sempre di porre la domanda giusta per aiutarlo a imparare a pensare con la propria testa. Devi sempre adattare la domanda all’interesse e alle conoscenze dello studente, suddividendo il problema in parti più semplici fino a raggiungere il livello giusto per lui“.

Ma non è perfetto

Anche con l’introduzione dei messaggi di sistema e degli altri aggiornamenti OpenAI riconosce che GPT-4 è ben lungi dall’essere perfetto.

Continua ad avere “allucinazioni” sui fatti e a commettere errori di ragionamento, a volte con grande sicurezza.

“GPT-4 generalmente non conosce gli eventi che si sono verificati dopo l’interruzione della maggior parte dei suoi dati (settembre 2021) e non impara dalla sua esperienza“, ha scritto OpenAI.

“A volte può commettere semplici errori di ragionamento che non sembrano compatibili con la competenza in così tanti domini, o essere eccessivamente ingenuo nell’accettare dichiarazioni palesemente false da parte di un utente. E a volte può fallire in problemi difficili proprio come fanno gli esseri umani, ad esempio introducendo vulnerabilità di sicurezza nel codice che produce“.

Source: http://www.ninjamarketing.it/